- 品牌

- Nvidia

- 型号

- H100

- 磁盘阵列

- Raid10

- CPU类型

- Intel Platinum 8558 48 核

- CPU主频

- 2.10

- 内存类型

- 64G

- 硬盘容量

- Samsung PM9A3 7.6TB NVMe *8

- 厂家

- SuperMicro

- 标配CPU个数

- 2个

- 最大CPU个数

- 4个

- 内存容量

- 64G*32

- GPU

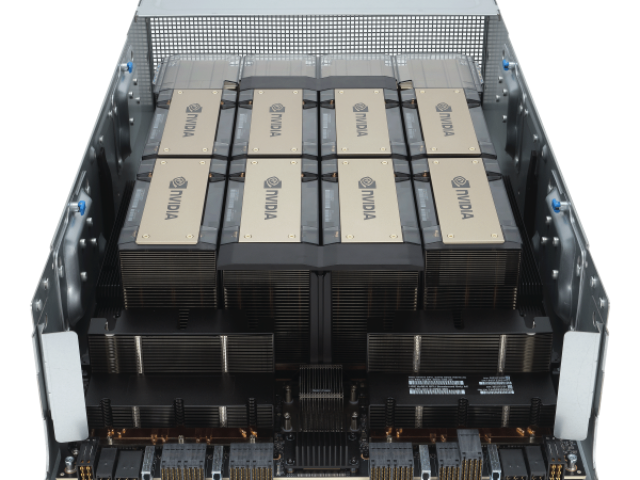

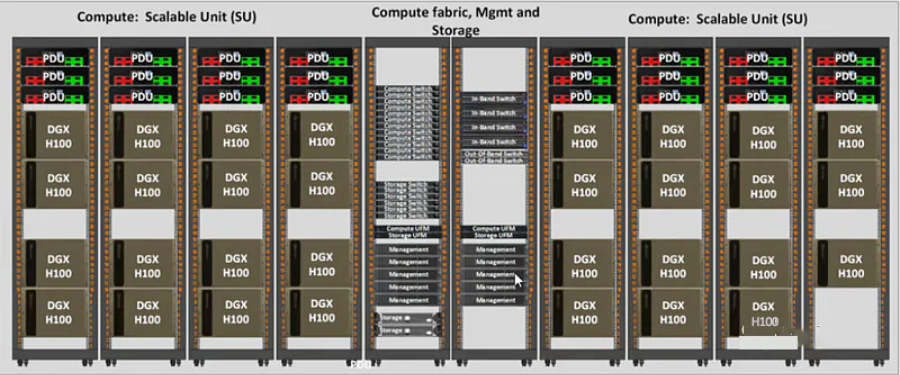

- 8 H100 80GB NVlink

网络、存储、RAM、CPU)以及销售它的人的利润率和支持级别。该范围的**,包括支持在内的$360k-380k,是您可能期望与DGXH100相同规格的。1xHGXH100(PCIe)和8xH100GPU大约是300k美元,包括支持,具体取决于规格。PCIe卡的市场价格约为30k-32k美元。SXM卡并不是真正作为单张卡出售的,因此很难在那里给出定价。通常作为4-GPU和8-GPU服务器出售。大约70-80%的需求是SXMH100,其余的是PCIeH100。SXM部分的需求呈上升趋势,因为PCIe卡是前几个月***可用的卡。鉴于大多数公司购买8-GPUHGXH100(SXM),每360个H380的大约支出为8k-100k,包括其他服务器组件。DGXGH200(提醒一下,包含256xGH200,每个GH200包含1xH100GPU和1xGraceCPU)的成本可能在15mm-25mm之间-尽管这是一个猜测,而不是基于定价表。19需要多少个GPU?#GPT-4可能在10,000到25,000架A100之间接受过训练。20Meta拥有大约21,000架A100,特斯拉拥有约7,000架A100,稳定AI拥有约5,000架A100。21猎鹰-40B在384架A100上进行了训练。22Inflection使用3,500H100作为其。23顺便说一句,到22月,我们有3k在运行。并且***运行超过5.<>k。——穆斯塔法·苏莱曼(MustafaSuleyman)。H100 GPU 支持 Tensor Core 技术。russiaH100GPU stock

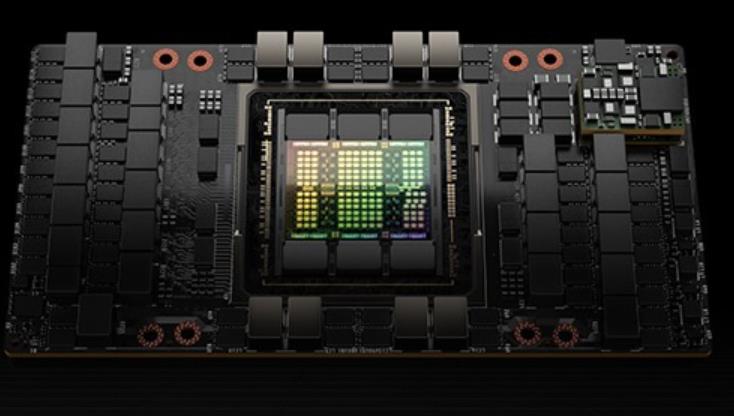

英伟达可以纯粹提高价格以找到清算价格,并且在某种程度上正在这样做。但重要的是要知道,终H100的分配取决于Nvidia更喜欢将分配分配给谁。供应H100显卡#造成瓶颈的原因-供应生产方面的瓶颈是什么?哪些组件?谁生产它们?谁制造了H100?#台积电。英伟达可以使用其他芯片厂进行H100生产吗?#不是真的,至少现在还没有。他们过去曾与三星合作过。但在H100和其他5nmGPU上,他们只使用台积电。这意味着三星还不能满足他们对前列GPU的需求。他们将来可能会与英特尔合作,并再次与三星合作,但这些都不会在短期内以有助于H100供应紧缩的方式发生。不同的台积电节点如何关联?#台积电5nm系列:N5264N要么适合作为N5的增强版本,要么低于N5PN5P4N要么适合作为N5P的增强版本,要么低于N5作为N5的增强版本N4N4PH100是在哪个台积电节点上制造的?#台积电4N。这是Nvidia的一个特殊节点,它属于5nm系列,并且是增强的5nm,而不是真正的4nm。还有谁使用该节点?#是苹果,但他们主要转向N3,并保留了大部分N3容量。高通和AMD是N5家族的其他大客户。A100使用哪个台积电节点?#N727晶圆厂产能通常提前多久预留?#不确定,虽然可能是12+个月。russiaH100GPU stockH100 GPU 支持多 GPU 配置。

可以在多个计算节点上实现多达256个GPU之间的GPU-to-GPU通信。与常规的NVLink(所有GPU共享一个共同的地址空间,请求直接使用GPU的物理地址进行路由)不同,NVLink网络引入了一个新的网络地址空间,由H100中新的地址转换硬件支持,以隔离所有GPU的地址空间和网络地址空间。这使得NVLink网络可以安全地扩展到更多的GPU上。由于NVLink网络端点不共享一个公共的内存地址空间,NVLink网络连接在整个系统中并不是自动建立的。相反,与其他网络接口(如IB交换机)类似,用户软件应根据需要显式地建立端点之间的连接。第三代NVSwitch包括驻留在节点内部和外部的交换机,用于连接服务器、集群和数据中心环境中的多个GPU。节点内部每一个新的第三代NVSwitch提供64个端口。NVLinklinks交换机的总吞吐率从上一代的Tbits/sec提高到Tbits/sec。还通过多播和NVIDIASHARP网内精简提供了集群操作的硬件加速。加速集群操作包括写广播(all_gather)、reduce_scatter、广播原子。组内多播和缩减能提供2倍的吞吐量增益,同时降低了小块大小的延迟。集群的NVSwitch加速降低了用于集群通信的SM的负载。新的NVLink交换系统新的NVLINK网络技术和新的第三代NVSwitch相结合。

ITMALL.sale 拥有丰富的行业经验和专业的技术团队,能够为客户提供专业的 H100 GPU 咨询和技术支持。ITMALL.sale 深知每个客户的需求都是独特的,因此在销售过程中注重与客户的沟通,了解其具体需求,提供量身定制的解决方案。ITMALL.sale 的技术团队能够帮助客户快速部署和优化 H100 GPU 系统,确保其能够充分发挥 H100 GPU 的强大性能,为客户的业务发展提供强有力的支持。

ITMALL.sale 拥有完善的供应链和物流体系,确保客户能够快速、便捷地获得 H100 GPU 产品。ITMALL.sale 与多家物流公司合作,能够提供灵活的配送服务,满足不同客户的配送需求。无论是大批量采购还是小批量订购,ITMALL.sale 都能够确保产品及时送达。ITMALL.sale 的仓储和物流团队经过专业培训,能够高效、安全地处理每一笔订单,确保产品在运输过程中完好无损地送到客户手中。 H100 GPU 限时降价,数量有限。

大多数GPU用于什么用途?#对于使用私有云(CoreWeave、Lambda)的公司,或拥有数百或数千台H100的公司,几乎都是LLM和一些扩散模型工作。其中一些是对现有模型的微调,但大多数是您可能还不知道的从头开始构建新模型的新创业公司。他们正在签订为期3年、价值1000万至5000万美元的合同,使用几百到几千台GPU。对于使用带有少量GPU的按需H100的公司来说,其LLM相关使用率可能仍>50%。私有云现在开始受到企业的青睐,这些企业通常会选择默认的大型云提供商,但现在大家都退出了。大型人工智能实验室在推理还是训练方面受到更多限制?#取决于他们有多少产品吸引力!SamAltman表示,如果必须选择,OpenAI宁愿拥有更多的推理能力,但OpenAI在这两方面仍然受到限制。H100 GPU 提供高效的功耗管理。香港H100GPU "text-indent:25px">H100 GPU 优惠促销,数量有限。russiaH100GPU stock

他们与英伟达合作托管了一个基于NVIDIA的集群。Nvidia也是Azure的客户。哪个大云拥有好的网络?#Azure,CoreWeave和Lambda都使用InfiniBand。Oracle具有良好的网络,它是3200Gbps,但它是以太网而不是InfiniBand,对于高参数计数LLM训练等用例,InfiniBand可能比IB慢15-20%左右。AWS和GCP的网络就没有那么好了。企业使用哪些大云?#在一个大约15家企业的私有数据点中,所有15家都是AWS,GCP或Azure,零甲骨文。大多数企业将坚持使用现有的云。绝望的初创公司会去哪里,哪里就有供应。DGXCloud怎么样,英伟达正在与谁合作?#“NVIDIA正在与的云服务提供商合作托管DGX云基础设施,从Oracle云基础设施(OCI)开始”-您处理Nvidia的销售,但您通过现有的云提供商租用它(首先使用Oracle启动,然后是Azure,然后是GoogleCloud,而不是使用AWS启动)3233Jensen在上一次财报电话会议上表示:“理想的组合是10%的NvidiaDGX云和90%的CSP云。大云什么时候推出他们的H100预览?#CoreWeave是个。34英伟达给了他们较早的分配,大概是为了帮助加强大型云之间的竞争(因为英伟达是投资者)。Azure于13月100日宣布H<>可供预览。35甲骨文于21月100日宣布H<>数量有限。russiaH100GPU stock

- 技嘉H100GPU货期 2024-11-15

- 硬盘H100GPU优惠 2024-11-15

- Dubai戴尔H100GPU 2024-11-15

- LenovoH100GPU distributor 2024-11-15

- 北京H100GPU 2024-11-15

- 英伟达H100GPU货期 2024-11-15

- NVLINKH100GPU list price 2024-11-14

- QatarH100GPU stock 2024-11-14

- 河南H100GPU库存 2024-11-14

- 广东H100GPU 2024-11-14

- 技嘉H100GPU多少钱 2024-11-14

- CPUH100GPU多少钱 2024-11-14